지난 5월, 구글의 연례 개발자 행사 Google I/O가 진행됐습니다. 구글의 가장 핵심적인 기술, 제품 전략, 개발자 도구, 그리고 인공지능 연구 방향까지 총체적으로 공개되는 자리로 애플의 WWDC 같은 행사라 볼 수 있죠. 이번 행사에서 정말 많은 기술이 쏟아졌습니다.

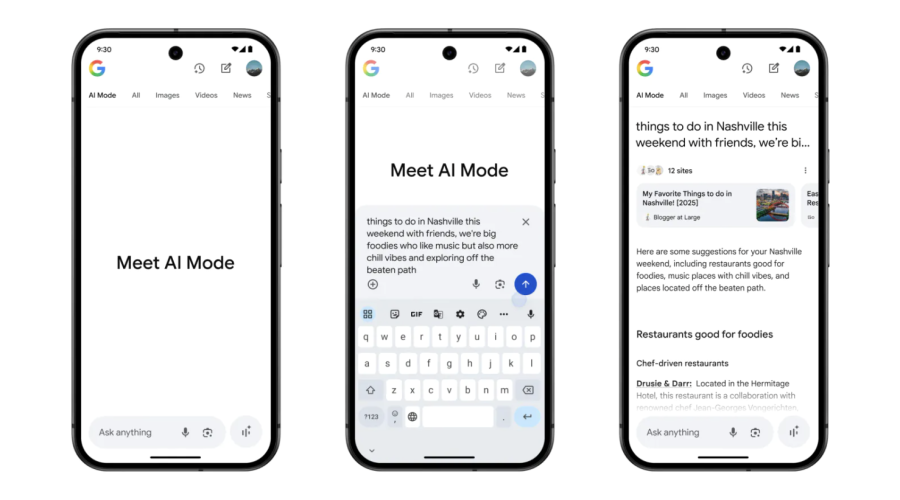

내 셀카를 올리면 구글에서 상품을 검색한 후 착용해 볼 수 있는 쇼핑 AI 기능, 에이전트 기반으로 가격을 추적해서 내 예산에 맞게 상품을 적절한 가격에 구매해 주는 기능, 영상과 오디오를 동시에 생성할 수 있는 Veo3, 실시간으로 음악을 만들고 조작할 수 있는 Lyria, AI 영화 제작 도구 Flow, 3D 영상 기술로 마치 같은 공간에 있는 듯한 대화 환경을 제공하는 Google Beam, AI가 탑재된 구글 글래스 등, 단순한 시연을 넘어 실제 서비스에 바로 적용될 수 있다는 점이 인상적이었습니다.

[AI에 ‘몸’이 필요한 이유]

이렇게 무서운 속도로 AI가 발전하고 있는데, 대체 어디까지 갈 수 있을까요? 이번 행사를 통해 구글 AI의 ‘몸’이라고 할 수 있는 TPU에 주목하게 됐습니다. AI가 더 많은 것을 해내려면 모델이 좋고, 알고리즘이 훌륭하면 끝나는 게 아니라, ‘하드웨어’가 필요하거든요. 예를 들어 ChatGPT에 우리가 뭔가를 질문할 때 GPT는 1초의 망설임 없이 바로 답을 합니다. 이 ‘바로’라는 게 정말 어렵습니다. 실제로는 그 한마디를 위해 뒤에서 수천 개의 컴퓨터가 동시에 작동하고, 수억 번의 계산이 벌어지고, 몇십 킬로미터 떨어진 데이터센터까지 신호가 왔다 갔다 합니다. 음성과 영상까지 동시에 처리하는 멀티모달(Multimodal)이 되면 그 계산량은 몇 배로 늘어나죠.

ChatGPT로 지브리풍 이미지 만들기가 유행했던 3월, 연산 수요가 너무 늘어나자 샘 알트먼은 “회사의 GPU가 녹아내리고 있다.”고 SNS에 올리기도 했습니다. 그만큼 AI를 더 많이, 더 빨리, 더 잘 사용하려면 어마어마하게 많은 GPU가 필요합니다.

[GPU라는 몸은 언제부터 사용됐을까]

AI 붐이 시작된 2010년대 중반, 대부분의 연구자들과 기업들은 AI 개발에 GPU(그래픽 처리 장치)를 사용했습니다. 원래는 게임 그래픽을 빠르게 처리하기 위해 만들어진 GPU는, 수많은 연산을 동시에 처리하는 데 강점을 가진 덕분에 AI 모델 학습에도 적합했습니다. 특히 엔비디아의 GPU는 AI 개발자들에게 잘 알려진 툴킷 CUDA를 제공하며 빠르게 업계 표준으로 자리 잡았고요. 사용도 쉽고, 이미 개발 환경이 갖춰져 있었기 때문에 누구나 GPU로 AI 개발을 시작했습니다.

하지만 시간이 지나면서 AI 모델의 크기와 복잡도가 급격히 커지기 시작했고, 그에 따른 새로운 문제가 생겼습니다. 수십억 개의 매개 변수를 갖는 모델을 훈련하려면, 수천 개의 GPU가 수주간 쉬지 않고 돌아가야 하는데요. 예를 들어, GPT-3는 약 3,000개의 GPU로 약 한 달간 학습된 것으로 알려져 있습니다. 그리고 이 GPU 하나의 시간당 비용은 약 23달러 수준이고요. 과거 엔비디아 H100의 경우, 시간당 45달러, 하루 100만 원이 넘는 사용료가 발생할 수 있었습니다. 단순 계산만 해도 초거대 AI 하나를 학습하는 데 수십억 원의 전기료와 장비 임대료가 드는 셈이죠.

[구글은 직접 칩을 만든다]

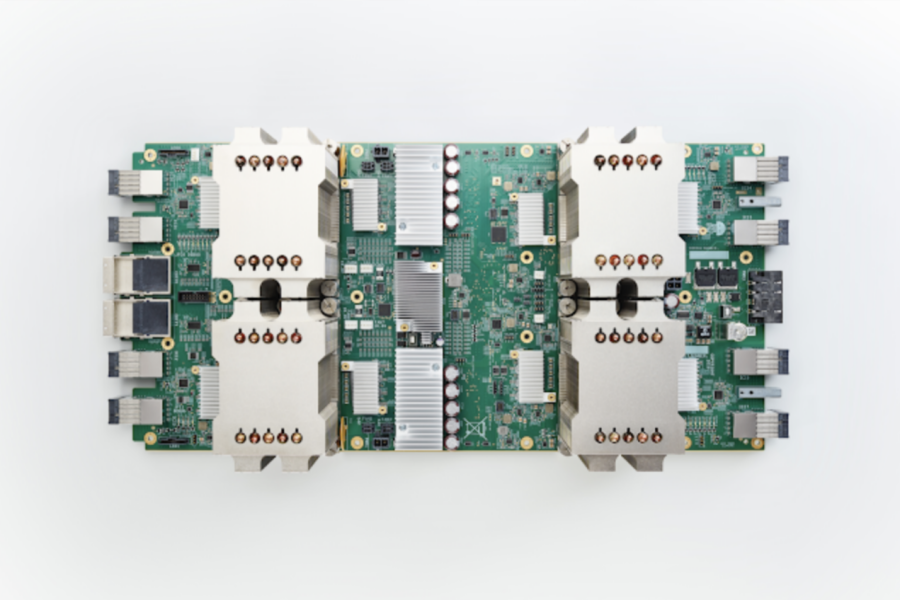

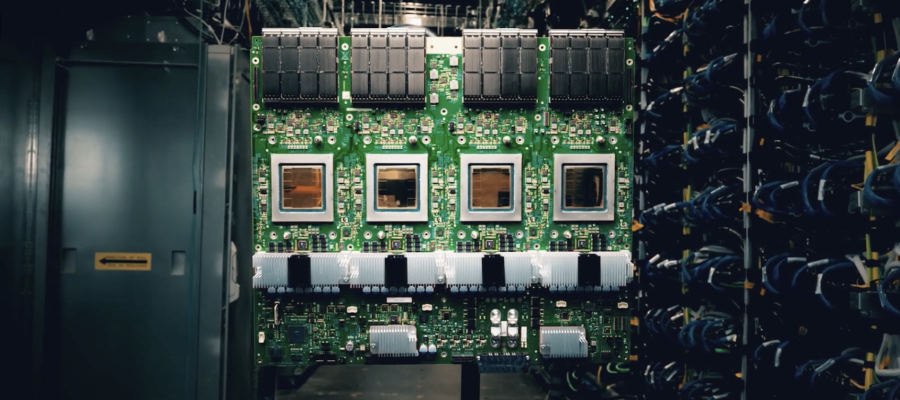

반면 구글은 GPU의 한계를 넘어서기 위해, AI만을 위한 ‘맞춤형 칩’ TPU를 직접 개발하기 시작했습니다. 2015년 첫 모델이 나왔으니 벌써 10년째 진행되고 있네요. GPU는 모두가 쓸 수 있는 범용 도구였다면, TPU는 구글이 자신들의 AI를 더 빠르게, 더 싸게, 더 많이 돌리기 위한 전용 기계인 셈입니다. 구글이 계속 엔비디아 GPU에 의존한다면 가격을 구글이 정할 수 없고, 성능이나 설계를 바꿀 수도 없겠죠. 구글은 이미 번역, 사진 분류, 검색, 광고, 유튜브 추천 등 모든 것에 AI가 필요한 상황이니 자연스러운 흐름입니다.

TPU(Tensor Processing Unit)는 인공지능 연산만을 목적으로 만들어진 ‘특수 맞춤형’ 부품입니다. 특히 AI가 가장 자주 수행하는 ‘행렬 곱셈’이라는 계산 작업을 놀라울 만큼 빠르고 효율적으로 처리하도록 설계되어 있습니다. 연산은 쉽게 말해 AI가 수많은 숫자 표를 비교하고 조합해 의미를 뽑아내는 과정입니다. 문장을 이해하거나 이미지를 인식하고, 음성의 감정을 파악하는 일은 결국 이 수학 연산의 반복으로 이뤄집니다. TPU는 이 작업에 특화되어 있어 GPU보다 더 빠르게, 더 적은 전력으로 계산을 끝낼 수 있습니다.

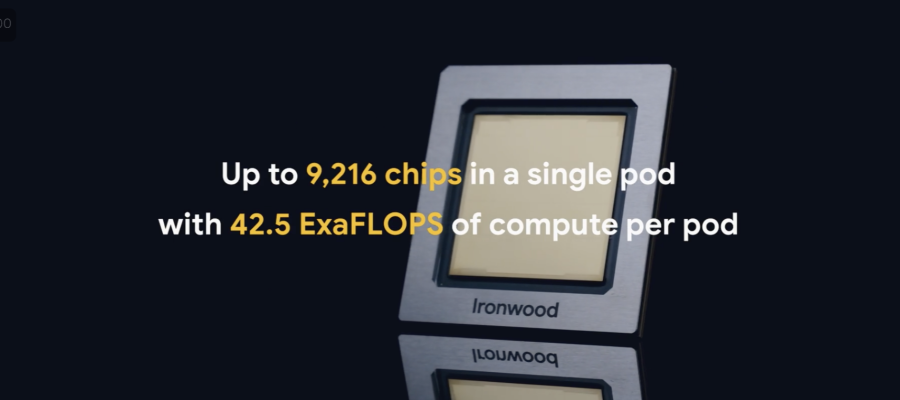

구글은 지난 4월 구글 클라우드 Next25 행사에서 추론에 특화된 7세대 TPU ‘아이언우드(Ironwood)’를 공개했습니다. 이전 모델(v5) 대비 성능이 10배 이상 개선됐는데, 포드(Pod)당 9,000개 이상의 칩을 탑재하고 42.5 엑사플롭스 연산 성능을 제공한다고 합니다. 이게 얼마나 거대한 숫자인지 감이 안 오실 텐데요. 엑사플롭스(Exaflops)는 1초에 100경 번 부동소수점 연산 처리하는 능력을 의미합니다. 세계 1위 슈퍼컴퓨터였던 Frontier가 약 1.1엑사플롭스였으니 이 컴퓨터의 40배 이상을 수행하는 것이고, 성능 좋은 게이밍 GPU로 알려진 RTX 4090 기준으로는 64,000개 분량에 해당합니다.

[이제 진짜 싸움은 ‘누가 몸을 가졌느냐’]

구글이 TPU를 만든 건 단지 ‘빠른 칩이 필요해서’가 아닙니다. 아무리 훌륭한 알고리즘을 만들어도, 그걸 실시간으로 돌릴 수 있는 환경이 없다면 사용자 입장에선 ‘느리고 비싼 AI’가 될 수밖에 없습니다. 특히 음성과 영상까지 동시에 처리하는 멀티모달 AI 시대에는, 계산량이 정말 말도 안 되게 늘어나거든요. 그래서 구글은 아예 칩부터 데이터센터, 소프트웨어까지 모든 걸 자기 손으로 설계하고 통제하는 구조를 만들고 있는 겁니다. TPU는 그렇게 해서 탄생한 결과물이고요.

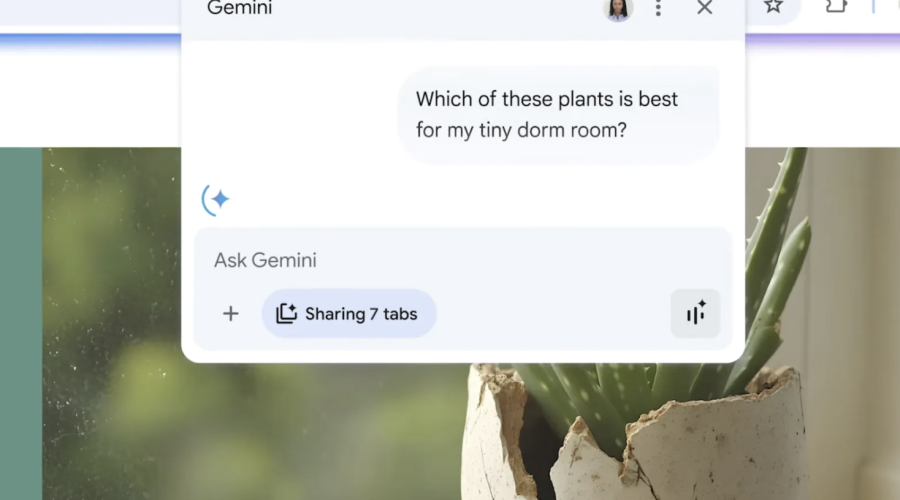

GPU는 모두가 사용할 수 있는 범용 장비라면, TPU는 구글이 자사 AI를 위해 ‘딱 맞게’ 만든 전용 장비입니다. 그러다 보니 더 빠르고, 더 싸게, 더 많은 연산을 처리할 수 있게 되는 거죠. 실제로 구글은 이걸 기반으로 지메일, 포토, 검색, 드라이브 등 거의 모든 서비스에 Gemini를 붙이고 있는데요. 그만큼 AI를 일상 속 깊은 곳까지 밀어 넣고 있습니다.

오픈AI는 아직 그런 구조를 갖추고 있지는 않습니다. GPT-4, GPT-4o 같은 뛰어난 모델을 내놓긴 했지만, 그걸 훈련하고 배포하는 환경은 마이크로소프트의 Azure 데이터 센터, 그리고 엔비디아의 GPU에 의존하고 있거든요. 칩도 남의 것, 클라우드도 남의 것, 운영체제도 마찬가지예요. 그래서 오픈AI도 2024년부터는 AI 칩을 직접 만들겠다고 선언했죠. 연산 비용을 줄이고, 독립적으로 AI를 운영할 수 있는 기반을 만들려는 겁니다. 요즘 보면 마이크로소프트, 아마존, 메타, 애플, 테슬라까지 거의 모든 빅테크 기업들이 AI 전용 칩을 만들고 있는데요. 이건 AI 전쟁의 다음 국면이 이미 하드웨어로 넘어가고 있다는 증거라고 볼 수 있습니다.

이런 변화는 기업들만의 문제가 아닙니다. 사용자 입장에서 봐도 그 차이는 점점 더 또렷해지고 있어요. 예를 들어 구글 포토에서는 Gemini에게 “이 사진들 좀 정리해줘”라고 말하는 것만으로 작업이 시작되죠. 별도로 앱을 실행하거나 설정을 바꿀 필요 없이, 기존에 쓰던 서비스 안에서 AI가 자연스럽게 붙어 있는 거예요. 반면 오픈AI의 GPT를 쓰려면 지금도 앱을 따로 켜거나 웹사이트에 접속해야 하잖아요. 이 차이는 결국 AI가 단순한 기능을 넘어서 ‘경험’이 되는 데 큰 영향을 주게 됩니다.

지금의 AI 경쟁은 단순히 모델의 똑똑함으로만 승부가 나는 시대는 아닙니다. 누가 더 빠르게 응답할 수 있느냐, 누가 더 낮은 비용으로 더 많은 계산을 할 수 있느냐, 그리고 누가 더 자연스럽게 AI를 우리의 일상에 녹여낼 수 있느냐가 핵심이죠. 그 모든 기준은 결국 하드웨어, ‘몸’에서 갈리게 됩니다. 구글은 TPU라는 몸을 미리 갖췄고요, 오픈AI는 지금 그 몸을 만드는 중입니다. 앞으로는 ‘누가 더 똑똑하냐’가 아니라, ‘누가 자기 AI를 자기 힘으로 더 잘 움직이느냐’가 진짜 중요한 질문이 될 수도 있습니다.